|

"Klassische" Rechnerarchitektur

Die meisten Computer, die heute verwendet werden, sind nach dem

Konzept organisiert, das John v. Neumann (zusammen mit Burks und Goldstine) in den Jahren 1944-1947 entwickelt hat:

problemunabhängige Struktur problemunabhängige Struktur

Universalrechner mit interner Programmspeicherung Universalrechner mit interner Programmspeicherung

v. Neumann-Architektur v. Neumann-Architektur

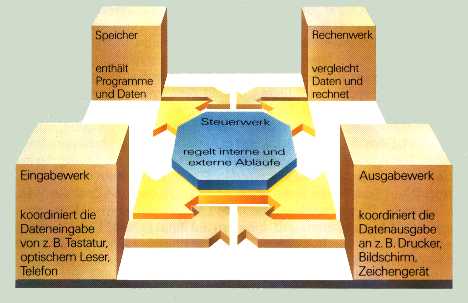

( "klassischer" Rechner) "klassischer" Rechner) Der v.Neumann-Rechner besteht aus 4 Funktionsgruppen:  - Speicher, der sowohl Programmbefehle als auch Daten aufnimmt (Hauptspeicher, Arbeitsspeicher, Main Memory). Die Daten/Befehle liegen binär verschlüsselt, also als 0/1-Folgen vor. Prinzipiell besteht kein Unterschied zwischen Daten und Befehlen. Unterteilung in Speicherplätze (Speicherzellen, Speicherworte), die über Adressen angesprochen werden.

- Steuerwerk, Leitwerk (Befehlsprozessor), das den Programmablauf steuert. Die Befehle werden interpretiert und deren Ausführung veranlasst, gesteuert und überwacht.

- Rechenwerk (Datenprozessor), das die zu bearbeitenden Daten verknüpft und verändert. Leitwerk und Rechenwerk bilden die zentrale Verarbeitungseinheit (CPU, Prozessor).

- Ein- und Ausgabewerk (E/A-Prozessoren), welche die Schnittstelle

zur Außenwelt (Peripherie) bilden. Zusammen mit den

E/A-Geräten besorgen sie die Kommunikation mit der realen Umwelt.

Der Informationsaustausch (Steuersignale, Daten/Befehle,

Adressen) zwischen diesen Funktionsgruppen erfolgt über

interne Datenwege. Diese können realisiert werden als direkte

Verbindung der einzelnen Funktionsgruppen oder als gemeinsame

Datenschiene  Busstruktur. Bei Mikros und Minis (z. B.

Workstation, PC) wird im allgemeinen die Busstruktur verwendet. Busstruktur. Bei Mikros und Minis (z. B.

Workstation, PC) wird im allgemeinen die Busstruktur verwendet.

Die Funktionsgruppen Speicher, Leitwerk, Rechenwerk, E/A-Werk

bilden zusammen mit den Verbindungswegen die Zentraleinheit

(ZE, CU, CPU) eines Computers. Die ZE wird häufig schon als

"Computer" bezeichnet. Zu einer vollständigen DVS

gehören jedoch noch die Peripheriegeräte. Dies

sind:

- Dateneingabe-Geräte

Lochkartenleser, Lochstreifenleser, Belegleser, Messfühler

(Sensoren), Messgeräte, A/D-Wandler, Digitalisierer

- Datenausgabe-Geräte

Lochkarten-Stanzer, Lochstreifen-Stanzer, Drucker, Plotter,

D/A-Wandler, Stellglieder

- Kommunikations- (Dialog-) Geräte

Tastenfeld, Datensichtgerät (Terminal), Modem, Maus,

Lichtgriffel, Sprach-E/A

- externe Speicher

Magnet-Trommel, Magnet-Band, Magnet-Platte, optische Platte

Operationsprinzip

Die CPU kann nur elementare, (fest verdrahtete) Befehle

verarbeiten ( Maschinenbefehle). Jedes Programm besteht also

aus einer Folge elementarer Befehle. Da im Speicher nicht zwischen

Daten und Befehlen unterschieden wird, muss das Leitwerk

entscheiden, ob der Inhalt einer Speicherzelle als Befehl oder

Datum aufzufassen ist. Es gibt somit zwei Zustände des

Rechners: Befehl holen (Interpretieren als Befehl) und Befehl

ausführen (Interpretation als Datum). Entsprechend gibt es

zwei Phasen der Programmabarbeitung: Maschinenbefehle). Jedes Programm besteht also

aus einer Folge elementarer Befehle. Da im Speicher nicht zwischen

Daten und Befehlen unterschieden wird, muss das Leitwerk

entscheiden, ob der Inhalt einer Speicherzelle als Befehl oder

Datum aufzufassen ist. Es gibt somit zwei Zustände des

Rechners: Befehl holen (Interpretieren als Befehl) und Befehl

ausführen (Interpretation als Datum). Entsprechend gibt es

zwei Phasen der Programmabarbeitung:

- 1. Phase:

Der (durch den sogenannten Befehlszähler) referierte

Speicherplatzinhalt wird geholt und als Befehl interpretiert

(Befehlsholphase, instruction fetch)

- 2. Phase:

Der Speicherplatzinhalt der durch den Befehl spezifizierten

Adresse wird geholt, als Datum interpretiert und dem Befehl

entsprechend verarbeitet (Befehlsausführungsphase, instruction

execution)

Dieses Zweiphasenschema erfordert eine streng sequentielle

Ausführung eines Programms, d.h. es sind zwar Sprünge

möglich, jedoch keine parallele Bearbeitung mehrerer Befehle.

Ein v. Neumann-Rechner bearbeitet zu jedem Zeitpunkt immer nur

einen Befehl, der immer eine Datenoperation im Rechenwerk bewirkt.

Typ SISD (single instruction, singel data) Typ SISD (single instruction, singel data)

Vorteile der v. Neumann-Architektur:

(Dies ist der Hauptgrund für ihre Langlebigkeit)

- Einfachheit (übersichtlich, minimaler HW-Aufwand)

- maximale Flexibilität (bei genügend elementaren Befehlen)

Nachteile der v. Neumann-Architektur:

- nur ein Prozessor

- nur ein Verbindungsweg zwischen CPU und Speicher (zwischen CPU

und Speicher wird immer nur ein Wort transportiert)

- sequentielle Verarbeitung von Befehl und Datum

v.

Neumann-Flaschenhals v.

Neumann-Flaschenhals

Durch neue Rechnerarchitekturen kann man die Nachteile des v.

Neumann-Rechners beseitigen, was aber erst durch die

stürmische Entwicklung auf dem Hardware-Sektor (sinkende

Preise, höhere Integrationsdichte, schnellere Chips,

höhere Zuverlässigkeit der Komponenten) möglich

wurde. Die neuen Architekturen werden (jedenfalls zur Zeit) den v.

Neumann-Rechner nicht ablösen, sondern nur in den Gebieten

sinnvoll ergänzen, in denen sie wirkliche Vorteile bringen.

Ein Weg ist z.B. der RISC (Reduced Instruction Set Computer), der

durch den vereinfachten Befehlssatz wesentlich schneller arbeitet.

Ein Teil der neuen Architekturen ist bereits in kommerziell

vertriebenen DVS vorhanden, ein Teil befindet sich im

Experimentierstadium und ein letzter Teil ist noch in der

Entwicklungsphase.

|

|

|